AI攻防最前線:針對深度時序分類模型的后門攻擊

責編:gltian |2022-11-03 18:06:34

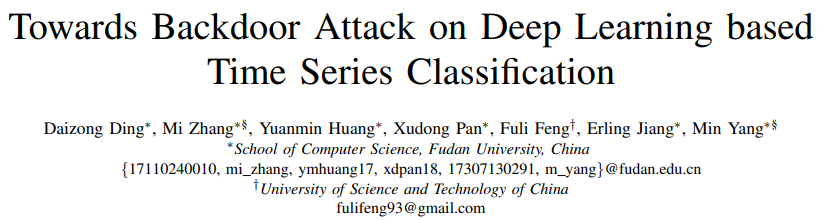

圖1 深度學習模型的后門風險示意圖

由于深度學習模型在時序分類上的高準確度,越來越多的商業(yè)系統采用深度學習模型來實現時序分類任務。考慮到訓練深度學習模型的高成本(訓練資源、訓練時間等),現有一種主流的商業(yè)解決方案是交給第三方資源來訓練模型,例如第三方訓練平臺(Amazon云服務)、第三方服務商等。但是這樣的方案往往會帶來相應的后門風險(圖1),例如攻擊者可以劫持或者攻擊第三方平臺,在深度學習模型中插入隱藏的功能。當模型在原環(huán)境部署后,雖然在正常樣本上有著很高的準確度,但是對于帶有觸發(fā)器的輸入就會有錯誤的預測行為。為了揭示現有系統在部署后會遇到的潛在威脅,本項目組提出對深度時序分類模型的后門攻擊做研究。

此前研究主要著眼于針對機器視覺任務的后門攻擊,例如對于圖片分類任務插入后門,技術框架是基于數據投毒的攻擊,即把正常樣本和帶有觸發(fā)器的樣本(標注為指定類別)同時交給模型訓練,經過訓練后,模型在正常樣本上仍然有高性能(攻擊隱蔽性),同時在帶有觸發(fā)器的樣本上預測指定類別(攻擊成功率)。從觸發(fā)器的角度看,主要可以分為兩類方法:靜態(tài)攻擊和動態(tài)攻擊。其中靜態(tài)攻擊的觸發(fā)器定義為圖片上的一塊特定樣式的像素,比如固定值的像素塊;而動態(tài)攻擊的觸發(fā)器定義為覆蓋全圖的噪聲擾動。為了研究時序任務上的后門風險,項目組先研究了已有后門攻擊算法在時序任務上的有效性。研究結果發(fā)現,靜態(tài)攻擊在此任務上的攻擊成功率非常低(15.6%),遠低于在機器視覺任務上的效果(通常是100%)。另一方面,雖然動態(tài)攻擊的成功率稍高(30.5%),但是經過數據投毒之后模型在正常樣本上的準確度從78.9%下降到68.7%,影響了模型在部署后的可用性。

針對上述問題,項目組首次提出了一個基于流形理論的分析框架,解釋了時序分類任務的后門攻擊難點。一方面,考慮到時序任務的流形維度較低,靜態(tài)攻擊中正常樣本和帶有觸發(fā)器的樣本在流形上的距離會非常小,如果把帶有觸發(fā)器的樣本標注為錯誤標簽,會造成模型很難建模這樣的不一致,導致較低的攻擊成功率。另一方面,由于低維度的性質,對樣本修改較多點會導致樣本飛出原本的流形空間,當注入這些樣本到訓練集之后,會使得訓練集的數據分布出現偏移,從而影響模型在正常樣本下的表現。

基于上述分析框架,項目組首次提出了一種針對深度時序分類模型后門攻擊的高效解決方案:(1)盡可能把觸發(fā)器的長度變小,使得帶有觸發(fā)器的樣本始終在原樣本流形空間上,保證后門攻擊的隱蔽性;(2)優(yōu)化觸發(fā)器的位置和具體值,而不是采用固定樣式的觸發(fā)器,使得模型會傾向于把帶有觸發(fā)器的樣本預測到指定類別,從而保證后門攻擊的成功率。

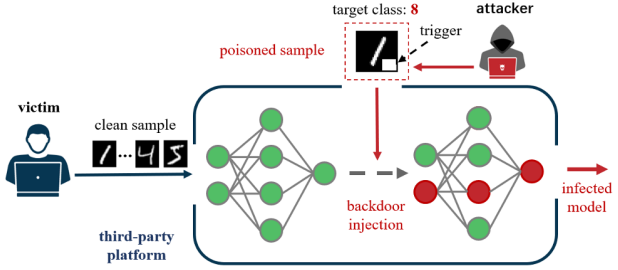

圖2 項目組提出的后門攻擊方案(TimeTrojan)

基于上述設計思想,項目組提出了一種針對時序分類模型的后門攻擊框架TimeTrojan。核心思路是一種迭代的攻擊策略,在每一輪會根據現有模型來生成最優(yōu)的帶有觸發(fā)器的樣本,然后交給模型做更新。在搜尋觸發(fā)器上,項目組提出了兩種策略:TimeTrojan-FGSM和TimeTrojan-DE,分別使用對抗樣本和進化差分算法來做優(yōu)化。項目組在三個標準時序分類數據集、六種深度學習模型上做了攻擊效果驗證,相比于之前的攻擊算法,TimeTrojan把平均的攻擊成功率從30.5%提升到了97.1%,同時模型的正常預測表現維持不變。

論文信息

本文成果發(fā)表于2022年5月舉辦的數據挖掘頂會IEEE International Conference on Data Engineering,作者為來自復旦大學系統軟件與安全實驗室的丁岱宗、張謐(教授)、黃元敏、潘旭東、姜爾玲、楊珉(教授)和中國科技大學大數據學院的馮福利(教授)。

Daizong Ding, Mi Zhang, Huang Yuanmin et al. Towards Backdoor Attack on Deep Learning based Time Series Classification, IEEE International Conference on Data Engineering (ICDE), 2022.

供稿:丁岱宗,復旦大學計算機科學技術學院系統軟件與安全實驗室

實驗室主頁:https://secsys.fudan.edu.cn/

來源:隱者聯盟