用AI檢測AI合規?谷歌公開AI合規檢查工具

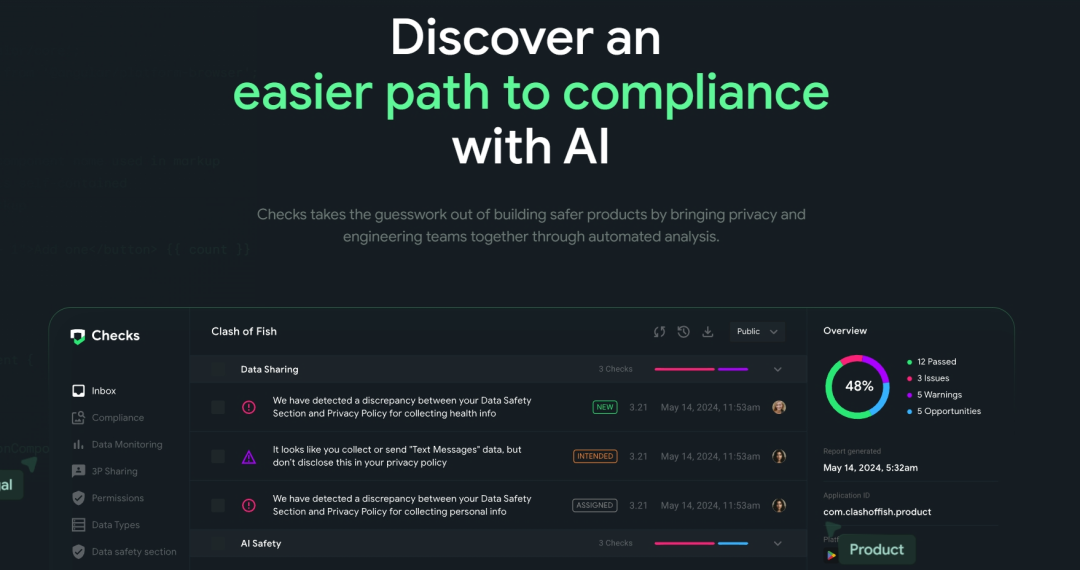

責編:gltian |2024-10-15 15:08:2010月10日消息,谷歌公開發布其內部工具“Checks”,該工具可以幫助評估應用程序、代碼和AI是否符合各種標準和法規,以應對監管要求。

該工具最初在谷歌內部使用,現在可以公開使用,并專注于合規性的三個關鍵領域——應用程序合規(App Compliance)、代碼合規(Code Compliance)和AI安全(AI Safety)。

01?主要功能

1.應用程序合規

應用程序合規性評估通過檢查應用程序或網站,確保其遵守用戶數據收集法規,這些法規例如歐盟GDPR(《通用數據保護條例》)、美國加州CCPA(《加州消費者隱私法案》)或巴西LGPD(《《通用數據保護法》》)。此外,它還可用于已經上線應用商店的應用程序。

整個“Checks”的系統基于AI大型語言模型運行,該模型經過微調,可理解不同的政策法規。因此,該系統通過檢查這些政策并將其與應用程序或網站進行比對,并利用AI爬蟲來檢查應用程序的功能。

谷歌表示,雖然用戶可以利用“Checks”獲得法律見解,但其設計目并不是提供法律建議或支持,而是主要用于標準政策檢查。

2.代碼合規性

目前,代碼合規性還處于封閉測試階段。不過,它可以幫助編碼人員在應用程序發布前檢查監管問題。用戶可以輕松地將其集成到開發環境中,并在構建系統時使用它來獲知潛在的風險。此外,它還能檢測如過時的SDK之類的關鍵問題。

3.AI安全

目前,AI行業的安全標準、道德和合規性仍在審查和評估中。例如,OpenAI正在為人工智能合規性和標準創建一個安全委員會。不過,要制定全行業的標準尚需時日。

由于人工智能系統是一個復雜的模型,因此通過谷歌的“Checks”工具對其進行全面評估具有一定的挑戰性。谷歌正在進行密集的封閉測試,試圖制定某些標準和政策以盡可能提供最好的合規性檢查。

人工智能安全檢查不僅可以進行合規性檢查,它還可以協助檢查來自大語言模型的表達、幻覺和有爭議的聲明或制作,比如那些帶有偏見或種族色彩的輸出結果。

02?“Checks”與AI安全

谷歌稱,“Checks”建立了一個整體性運行框架可以覆蓋開發人員使用AI產品時需要解決三個主要階段的問題,分別是:

第一階段“對齊階段”:確定哪些政策法規與AI產品相關。

第二階段“評估階段”:確保初始模型版本可以完成開發所設定的預期任務。

“Checks”對AI模型進行“紅隊測試 ”和“提示詞測試”,檢測AI產品的是否存在安全隱患,并根據所選定的相關國家或地區法律法規檢測AI產品在暴力、仇恨言論和敏感數據(如個人身份信息)方面的輸出結果符合預期。

第三階段“監控階段”:在AI產品推出后,開發人員需要檢查它在實際環境中可以正常、正確運行,確保不會被盜用或被黑客入侵。

例如,曾經有這樣一個案例:一家公司推出了一個通用人工智能代理,為特定場景提供服務,但人們發現他們可以“黑”它,從而免費盜用這個模型,但這個模型的開發成本實際上非常高。

“Checks”可以監控輸入提示和輸出提示并檢測問題,比如當有人試圖對模型進行駭入時,輸入提示就會被阻止到達模型;任何個人隱私數據的輸出行為也都會被檢測。

03?初始版本

“Checks by Google”早在2023年5月就在谷歌官方的一篇博客中被提及。

谷歌稱在這篇博客中稱,“Checks”最初于2022年作為Google內部孵化器的一部分推出,用于快速發現和解決Google Play和iOS商店中的應用程序的隱私合規性問題,該初始版本具有3個關鍵產品領域:

- 1.合規性監控(Compliance Monitoring)通過使用自動化測試來掃描應用程序及其隱私披露情況,幫助公司識別潛在的法規和移動應用商店合規性問題,并提供可操作的建議來幫助解決任何已發現的問題。

- 2.數據監控(Data Monitoring)提供應用程序數據收集和共享行為的端到端可見性,使開發運營團隊能夠更高效地、集成地管理其數據治理。

- 3.商店披露支持(Store Disclosure Support)可幫助公司確保其開發的程序符合Google Play數據安全要求。

來源|Checks官網

編譯|尚健

審核|唐巧盈