危機四伏,如何打響機器學習保衛(wèi)戰(zhàn)?

責編:gltian |2023-07-14 16:14:21在過去的一年里,我對人工智能的迅猛發(fā)展和創(chuàng)新感到非常驚嘆。隨著對人工智能和機器學習模型的采用持續(xù)增加,“數(shù)據(jù)是新石油”的傳統(tǒng)說法終于需要更新了。在2023年這個以人工智能為核心的世界中,“數(shù)據(jù)和模型是新石油”似乎更具前瞻性。

作為從事安全工作多年的人,我深知任何偉大的技術都可能被用于造成傷害(例如社交媒體、互聯(lián)網)。本文并非要阻止創(chuàng)新本身,也不是一種無害的進步預言者,而是要在考慮安全的基礎上思考安全行業(yè)將如何發(fā)展以及機器學習安全在未來十年甚至更長時間的重要性。為此,我在過去幾個月中與領域內的建設者、購買者和普通從業(yè)人員進行了廣泛的交流,很高興能與大家分享我的學習成果。

當前態(tài)勢和新漏洞可能

機器學習安全,或稱為ML安全,旨在保護機器學習模型、數(shù)據(jù)集以及整體工作流程的完整性、機密性和可用性。傳統(tǒng)的網絡安全措施通常著重于保護網絡和應用程序,而ML安全則主動保護驅動機器學習系統(tǒng)的復雜算法和模型。

隨著我們深入進行地殼運動般的人工智能轉變,對強大的ML安全措施的需求變得更加迫切。數(shù)據(jù)泄露和網絡攻擊的增多,再加上企業(yè)中開源軟件(OSS)模型的采用,造成了潛在漏洞的完美風暴。攻擊者越來越頻繁地針對機器學習模型進行攻擊,以操縱輸出、破壞功能或獲取敏感信息。

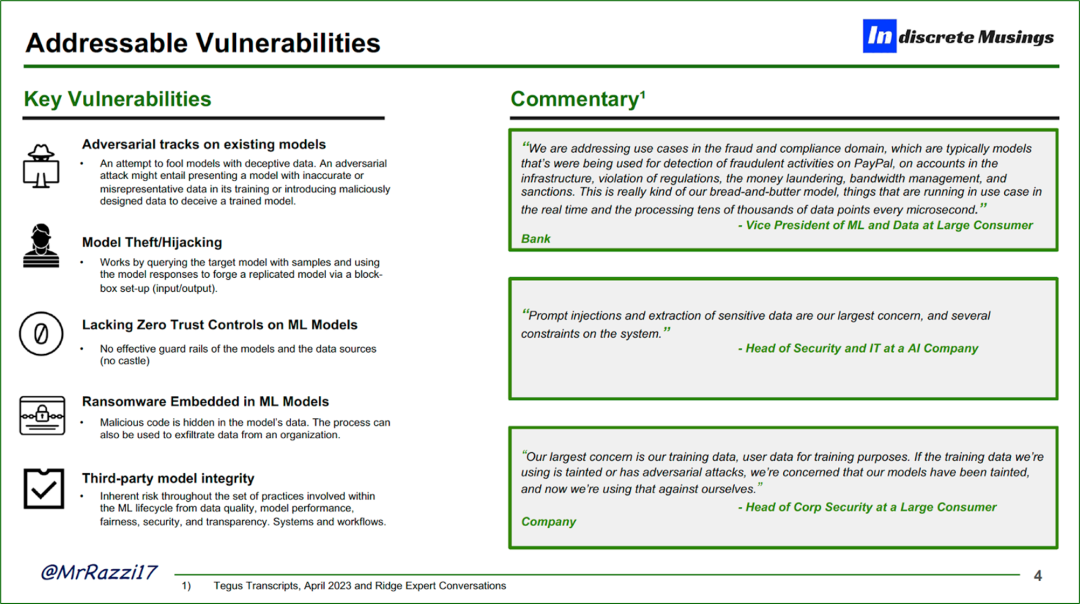

當前企業(yè)面臨的一些關鍵漏洞包括:

- 對現(xiàn)有模型的對抗性追蹤

- 模型盜竊和劫持

- 無法在內部進行大規(guī)模的防護策略供應(例如零信任控制)

- 嵌入在采用OSS模型中的勒索軟件

- 在模型生命周期(生產前/生產后)中保持模型的完整性

機器學習模型變得更加復雜和不透明。深度學習模型可以包含數(shù)百萬個參數(shù)和層次,使得理解其內部運作和漏洞變得困難。一些漏洞正在變得常見,但在未來的十年中,我們仍將面臨新的攻擊途徑。

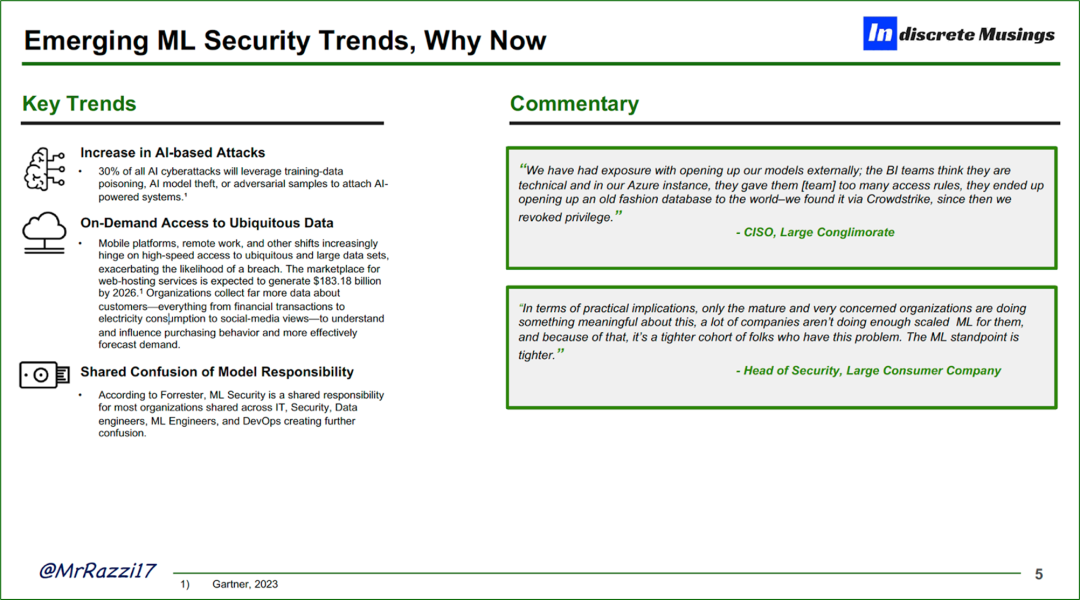

新興的趨勢

機器學習并不是新的技術,但從這個角度來看,我們正在進入一個關鍵的十年,關于機器學習的實踐和供應鏈本身的安全保護方面。我認為,行業(yè)尤其是保護該領域的重要性,還得到了三個關鍵新興趨勢的支持,這些趨勢突顯了專注于保護機器學習供應鏈的重要性:

- 人工智能攻擊的增加:所有人工智能網絡攻擊中,有30%利用了趨勢性數(shù)據(jù)污染、人工智能模型盜竊和附加在人工智能核心上的對抗性樣本。

- 數(shù)據(jù)擴張:如今,企業(yè)每天都在產生海量的數(shù)據(jù),移動平臺和遠程辦公等平臺轉變是其主要原因,企業(yè)負責收集客戶數(shù)據(jù),并更重要的是保護這些數(shù)據(jù)的安全。

- 責任分攤的混亂:機器學習涉及到多個團隊,包括商業(yè)智能、數(shù)據(jù)科學團隊、機器學習工程師、IT、安全等等。類似于由大規(guī)模技術擴展者引領的共享責任模型,越來越多的公司難以承擔起對模型的責任,從而使自己暴露于惡意攻擊之下。

在這些趨勢和其他一些因素的推動下,對于成熟和復雜的組織來說,機器學習安全將始終是頭等大事。

在董事會層面上,最近一個常見的話題是,不管是在應用層還是基礎架構層,你的公司有什么“AI”戰(zhàn)略。對于許多企業(yè)來說,人工智能是頭等大事。我注意到,更多技術實力強大的公司正在采用開源模型,將“AI化”的組件化部分納入其產品中。

然而,這也是一個雙刃劍,開源模型的采用更具前瞻性,因為企業(yè)從客戶那里收集的數(shù)據(jù)很可能(也應該)不能離開他們的環(huán)境,無論是出于監(jiān)管擔憂、合規(guī)要求還是純粹的安全監(jiān)管。因此,結合開源模型的采用,確保數(shù)據(jù)/模型不離開您的環(huán)境,以及少數(shù)復雜企業(yè)的需求,機器學習安全公司在這方面有很大的發(fā)展機遇。

部署方式

在考慮機器學習安全的部署方法時,從大多數(shù)企業(yè)的角度出發(fā),從機器學習的工作流程開始是至關重要的。請原諒我并非機器學習專家,因此以下是非常簡化的工作流程。有許多工具和方法可用于保護機器學習供應鏈。我將機器學習安全的安全態(tài)勢分為四個明確的類別:

- 數(shù)據(jù)準備 – 合成數(shù)據(jù)提供商:合成數(shù)據(jù)提供商是專門生成合成或人工創(chuàng)建數(shù)據(jù)以模擬真實數(shù)據(jù)并保持隱私和匿名性的公司或服務。以下是使用案例和示例:

- 數(shù)據(jù)生成:合成數(shù)據(jù)提供商開發(fā)算法和方法來生成合成數(shù)據(jù)。他們的目標是創(chuàng)建與真實數(shù)據(jù)的統(tǒng)計特性和模式非常相似的數(shù)據(jù),包括生成數(shù)據(jù)點、建立變量之間的關系和復制目標數(shù)據(jù)的特征。

- 隱私保護:合成數(shù)據(jù)的一個重要優(yōu)勢是保護原始數(shù)據(jù)集中個人的隱私和機密性。合成數(shù)據(jù)提供商采用數(shù)據(jù)匿名化、去標識化和差分隱私等方法,確保個人信息無法與特定個體關聯(lián)起來。

- 數(shù)據(jù)定制化:合成數(shù)據(jù)提供商允許用戶在生成的數(shù)據(jù)中指定所需的特征和屬性。這種定制化可以包括定義變量的分布、確定屬性之間的關聯(lián)性以及控制數(shù)據(jù)集的整體結構。用戶可以根據(jù)自身需求和研究要求來定制合成數(shù)據(jù)。

- 真實數(shù)據(jù)表現(xiàn):合成數(shù)據(jù)提供商致力于創(chuàng)建能夠準確反映目標領域真實場景和挑戰(zhàn)的數(shù)據(jù)。這涉及捕捉原始數(shù)據(jù)中的復雜性、模式和異常情況,使用戶能夠進行有意義的分析和測試。

- 可擴展性和多樣性:合成數(shù)據(jù)提供商通常提供可擴展的解決方案,可以生成大量數(shù)據(jù)以滿足不同用例的需求。他們能夠創(chuàng)建具有各種場景、異常值和邊緣情況的多樣化數(shù)據(jù)集,全面代表目標領域。

- 驗證和評估:合成數(shù)據(jù)提供商可能提供工具和技術來評估生成的合成數(shù)據(jù)的質量和有效性。這可能涉及統(tǒng)計分析、可視化和與原始數(shù)據(jù)集的比較,以確保合成數(shù)據(jù)準確捕捉到實際數(shù)據(jù)的特征。

- 集成和部署:一旦生成了合成數(shù)據(jù),提供商可能會協(xié)助用戶將其集成到現(xiàn)有的工作流程和系統(tǒng)中。他們可以提供API、數(shù)據(jù)格式或集成支持,以促進將合成數(shù)據(jù)無縫地整合到各種應用和平臺中。

- 模型的訓練和驗證 – AI防火墻:

- 行為分析:AI防火墻從歷史數(shù)據(jù)/模型中學習并建立用戶、設備和應用程序的基準行為。然后它們可以檢測與預期模型模式的偏離,例如異常的網絡流量、訪問嘗試或數(shù)據(jù)傳輸,這可能表明存在安全漏洞。

- 零日威脅檢測:零日漏洞是指在安全補丁或修復程序發(fā)布之前,黑客利用的先前未知的安全漏洞。AI防火墻可以分析網絡行為并識別異常活動,這可能表明存在零日攻擊,并提供早期警告和主動防御機制。考慮到開源軟件(OSS)模型的興起,零日檢測變得至關重要。

- 模型驗證和部署 – 模型注入保護:

- 對抗性攻擊:對抗性攻擊涉及操縱輸入數(shù)據(jù)以誤導或欺騙機器學習模型。這些攻擊可以旨在繞過安全措施、導致錯誤分類或利用模型中的漏洞。模型注入保護有助于檢測和緩解此類攻擊。

- 輸入驗證:模型注入保護涉及在機器學習模型用于推理或決策之前對輸入數(shù)據(jù)進行驗證和清理。這個過程確保輸入符合預期的格式、范圍或約束,降低注入惡意或未經授權內容的風險。

- 數(shù)據(jù)完整性檢查:模型注入保護可能包括驗證模型本身的完整性和真實性的機制。這可以涉及使用密碼技術、數(shù)字簽名或校驗和來確保模型自創(chuàng)建或部署以來沒有被修改或篡改。

- 模型驗證:模型注入保護可以涉及對機器學習模型進行定期或連續(xù)監(jiān)控,以確保其完整性。這可以包括驗證模型的架構、參數(shù)和權重,以檢測任何未經授權的更改或篡改。

- 運行時異常檢測:模型注入保護可能在運行時使用異常檢測技術,以識別機器學習模型的異常行為或意外輸出。這有助于檢測潛在的模型注入攻擊并觸發(fā)適當?shù)捻憫獧C制。

- 訪問控制和身份驗證:模型注入保護可以涉及實施訪問控制機制和身份驗證協(xié)議,以防止未經授權的訪問或修改模型。這包括保護托管模型的基礎設施,控制模型更新的權限,并為授權用戶實施強大的身份驗證機制。

- 模型監(jiān)控 – AI/ML可觀測性:

- 監(jiān)控和日志記錄:AI/ML 可觀測性公司提供監(jiān)控和日志記錄功能,用于跟蹤AI/ML模型、基礎設施和數(shù)據(jù)管道的行為和性能。它們收集和分析各種指標、日志和事件,以提供對系統(tǒng)健康狀況、資源利用情況、數(shù)據(jù)質量和其他相關參數(shù)的可見性。

- 性能和效率優(yōu)化:這些公司幫助組織優(yōu)化其AI/ML系統(tǒng)的性能和效率。它們提供工具和技術來識別瓶頸、低效和資源限制,使企業(yè)能夠微調模型、提高訓練和推理速度,并優(yōu)化資源分配。

- 數(shù)據(jù)質量和漂移監(jiān)控:AI/ML可觀測性公司專注于監(jiān)控AI/ML管道中的數(shù)據(jù)質量和檢測數(shù)據(jù)漂移。它們幫助組織識別缺失或不完整的數(shù)據(jù)、異常值、概念漂移或數(shù)據(jù)分布的變化,這些因素可能會影響模型性能。通過監(jiān)控數(shù)據(jù)質量和漂移,企業(yè)可以采取糾正措施并保持模型準確性。

- 異常檢測和根本原因分析:這些公司提供異常檢測功能,用于識別AI/ML系統(tǒng)中的異常行為或偏離。通過分析指標、日志和其他數(shù)據(jù)來源,企業(yè)可以識別和診斷問題,及時進行干預和根本原因分析,以解決問題并確保系統(tǒng)的可靠性。

- 模型可解釋性和可理解性:AI/ML可觀測性公司提供工具和技術來增強模型的可解釋性和可理解性。它們提供關于模型如何進行預測、特征重要性和模型決策過程的見解。這有助于組織理解和驗證模型的行為,確保公平和透明,并遵守監(jiān)管要求。

- 警報和通知:AI/ML 可觀測性公司提供警報和通知機制,及時向利益相關者通報系統(tǒng)問題、異常情況或與預期行為偏離的情況。這使得可以及時響應和采取措施,以減輕潛在問題或性能下降的影響。

- 可視化和報告:這些公司提供可視化和報告功能,以用戶友好和可操作的格式呈現(xiàn) AI/ML 系統(tǒng)的指標、趨勢和見解。可視化工具幫助利益相關者了解 AI/ML 模型的性能、行為和影響,并促進決策過程。

- 集成和協(xié)作:AI/ML 可觀測性公司確保與現(xiàn)有的 AI/ML 基礎設施、數(shù)據(jù)管道和監(jiān)控生態(tài)系統(tǒng)無縫集成。它們可能提供 API、集成和協(xié)作功能,以簡化可觀測性過程,并促進數(shù)據(jù)科學家、開發(fā)人員和運營團隊之間的跨職能協(xié)作。

安全產品套件和復雜性

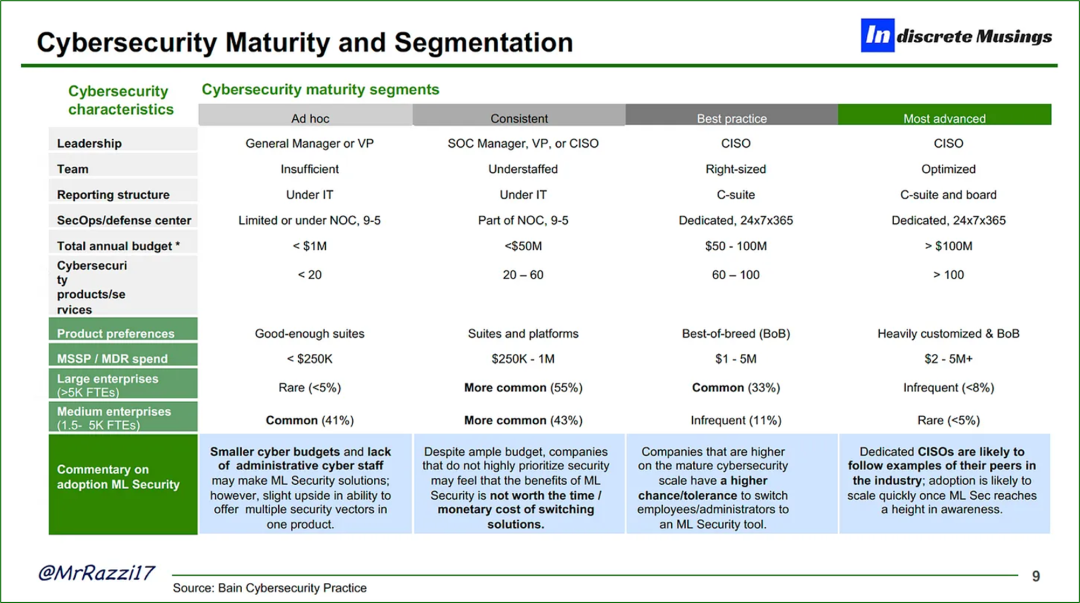

考慮到上面提到的機器學習安全方法,值得注意的是安全產品的類型和使用場景可能存在重疊。在行業(yè)中,安全產品往往會有重疊,無論是端點安全、身份和訪問管理(IAM)還是漏洞管理,機器學習安全也不例外。機器學習安全與多個不同的安全類別有重疊,涵蓋了從身份驗證到端點保護等多個方面的安全。與安全領域的情況相似,該領域的工具應該與CISO使用的整個產品套件相輔相成。如果您是一個新公司,在銷售安全產品時應考慮所面向的安全復雜性類型,通常他們會使用2-3個供應商的產品,而產品套件之間可能存在重疊。機器學習安全跨越了多個產品套件,并被視為買方的增值購買。

根據(jù)專家訪談,機器學習安全在“最佳實踐”和“最先進”的安全組織中是必需的。這些組織通常會優(yōu)化安全冗余,選擇一到兩種最佳工具。他們的安全預算通常接近5,000萬美元甚至更高。如果您是一家機器學習安全公司,我強烈建議您專注于成熟企業(yè),這些企業(yè)完全符合這些特征。此外,內部和客戶數(shù)據(jù)團隊(如機器學習、數(shù)據(jù)、DevOps團隊)的水平可能達到局部最大值,他們對機器學習安全的關注程度非常高,確保其安全至關重要。經過與幾位CISO和買家的交談,我了解到,在能夠在客戶環(huán)境(如VPC)中部署產品的架構非常關鍵。

相關行業(yè)

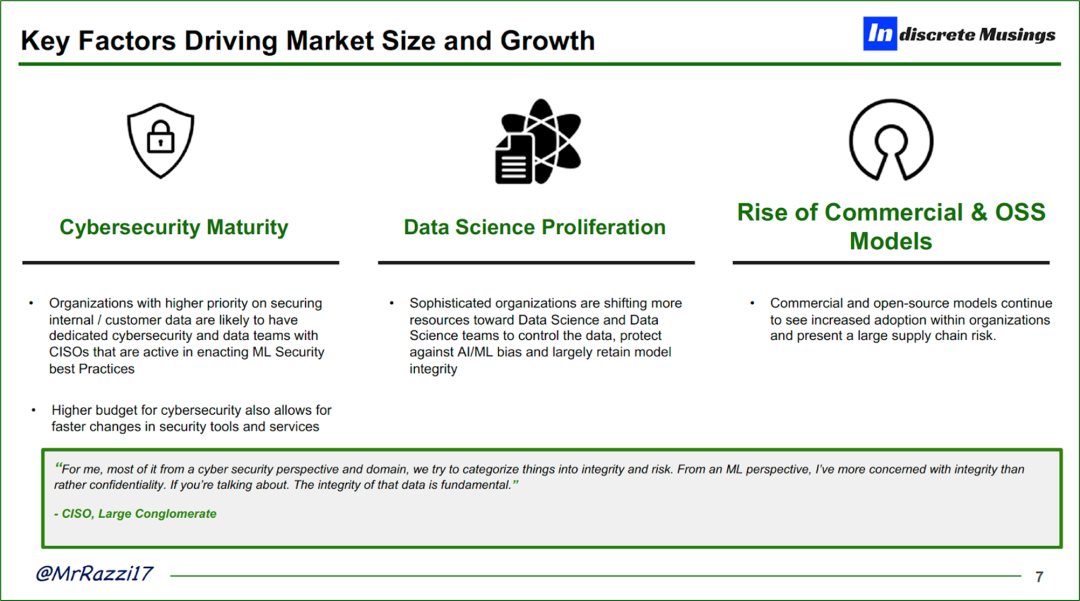

可以說,盡管機器學習安全領域還處于初期階段,但它與一些行業(yè)密切相關,涵蓋了從科技到工業(yè)的一系列行業(yè)。我將這些行業(yè)分為三個分類:安全成熟度(如網絡安全成熟度細分)、數(shù)據(jù)科學的復雜性,以及內部采用開源模型的可能性。雖然這只是一個初步了解哪些行業(yè)最需要機器學習安全的簡單方法,但它為了解哪些行業(yè)更容易受到攻擊,從而更有可能購買新興競爭對手的產品奠定了基礎。毫不奇怪,“科技”行業(yè)似乎是一個相關的目標,因為他們具備先進的技術能力,并有可能采用開源模型。另外兩個相關的行業(yè)是金融軟件行業(yè)——考慮到其涉及到的客戶數(shù)據(jù)和為消費者相關產品運行實時模型所需的高級技術。最后一個相關行業(yè)是保險業(yè)。鑒于保險業(yè)的特性,其業(yè)績與模型本身緊密相關,攻擊者充分意識到模型的重要性以及輸入數(shù)據(jù)對輸出結果的巨大影響。

當前市場現(xiàn)狀

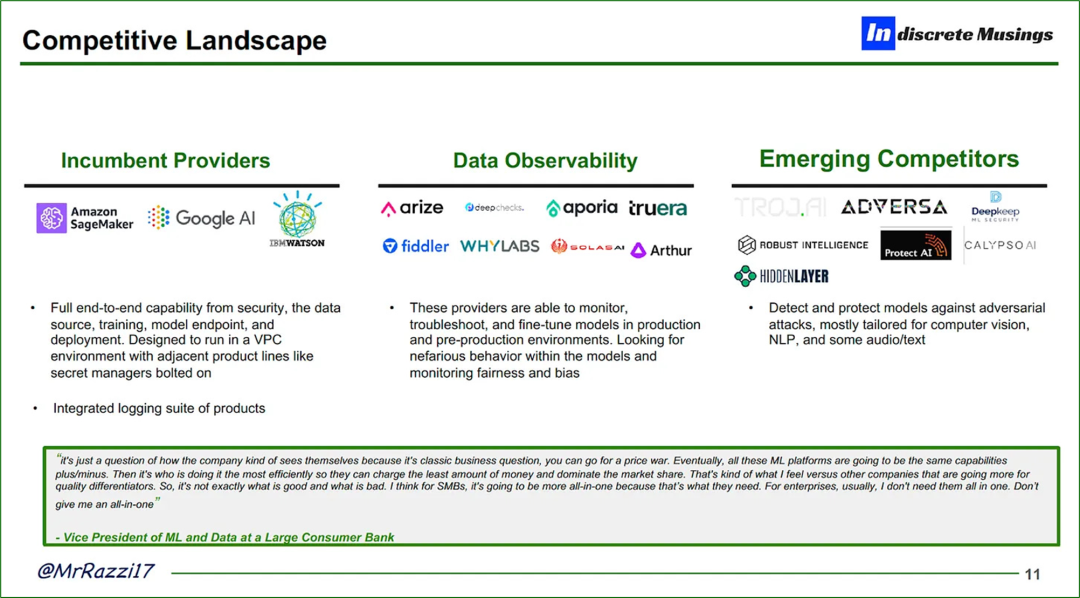

當前市場仍然相對初級;針對目前的供應商,我將它們分為三個新興類別:

現(xiàn)有供應商(如Amazon Sagemaker、Google AI):

- 這些供應商以提供從數(shù)據(jù)倉儲、安全性、訓練到模型部署的完整端到端能力而聞名。

- 針對“最先進”的安全性領域設計,同時具備必要的企業(yè)附屬功能,如日志記錄。

ML/AI可觀測性(如Arize、Arthur、Fiddler):

- 這些供應商以能夠監(jiān)測、排除故障和優(yōu)化生產環(huán)境和預生產環(huán)境中的模型而聞名。

- 其初始重點是內部和性能方面,以檢查合規(guī)的人工智能(偏見)、數(shù)據(jù)探索、模型性能和漂移。

- 較少關注安全性,因為安全性往往是一種從外部到內部的關注。

新興競爭者(如Robust Intelligence、HiddenLayer、Protect.ai):

- 能夠保護模型免受對抗性攻擊。

- 在模型部署的全過程中實施人工智能防火墻和訪問控制。

- 能夠檢查來自流行的開源平臺(如Hugging Face等)的模型有效性。

- 實施模型驗證程序以對機器學習模型進行持續(xù)監(jiān)控,確保其完整性。

更進一步,細致的論點

在與幾位專家和CISO(首席信息安全官)進行交流后,我們可以得出結論:機器學習安全將成為少數(shù)幾家企業(yè)關注的焦點,主要集中在一小部分行業(yè)中。目前尚不清楚獲勝的組合將會是什么樣的,但毫無疑問,安全領域即將發(fā)生重大變革。因此,在結束時,我將為您列出一些市場相關的細節(jié)和對于該領域的綜述:

? 隨著數(shù)據(jù)在數(shù)據(jù)倉庫和協(xié)作層之間的持續(xù)增加,能夠以零信任的方式(對數(shù)據(jù)、協(xié)作者和模型進行隔離)來處理價值鏈的每個部分的供應商將在市場上受到青睞。

? 解決方案必須針對復雜的組織,并采用自上而下的市場推廣方法。

? 理想的供應商必須愿意制定MSSP(托管安全服務提供商)方法,考慮到行業(yè)的細微差別以及MSSP在滿足大型組織安全需求方面所贏得的信任。

? 理想的解決方案應該以架構方式部署到客戶環(huán)境中(例如VPC),并能夠在多個云環(huán)境中擴展。

? 針對復雜的企業(yè),理想的提供商需要專注于訓練數(shù)據(jù)、驗證和部署數(shù)據(jù)層,而較大型企業(yè)則不太愿意采用一攬子解決方案。

? 理想的提供商將希望能夠實現(xiàn)平均及以上的SaaS ACV(年度合同價值),就像一些市場領導者和企業(yè)在支付/增加新工具方面的傾向所示。

? 開放源代碼(OSS)模型的可防御性將至關重要;考慮到OSS的快速發(fā)展性質,理想的提供商將希望早日建立一個安全研究機構,以應對新的攻擊方式。

? 初期的突破點應集中在“最佳實踐”和“最先進”的網絡安全成熟度領域。

作者:Zain Rizavi@Ridge Ventures

相關鏈接:https://indiscretemusings.substack.com/p/fortifying-the-future-safeguarding

來源:安全喵喵站

- ISC.AI 2025正式啟動:AI與安全協(xié)同進化,開啟數(shù)智未來

- 360安全云聯(lián)運商座談會圓滿落幕 數(shù)十家企業(yè)獲“聯(lián)營聯(lián)運”認證!

- 280萬人健康數(shù)據(jù)被盜,兩家大型醫(yī)療集團賠償超4700萬元

- 推動數(shù)據(jù)要素安全流通的機制與技術

- RSAC 2025前瞻:Agentic AI將成為行業(yè)新風向

- 因被黑致使個人信息泄露,企業(yè)賠償員工超5000萬元

- UTG-Q-017:“短平快”體系下的高級竊密組織

- 算力并網可信交易技術與應用白皮書

- 美國美中委員會發(fā)布DeepSeek調查報告

- 2024年中國網絡與信息法治建設回顧